夫妻车内赤裸激情 下一幕路人惊呆,文徽明习字,太阳雨太阳能

这篇文章本来是继续分享identityserver4 的相关文章,由于之前有博友问我关于微服务相关的问题,我就先跳过identityserver4的分享,进行微服务相关的技术学习和分享。微服务在我的分享目录里面是放到四月份开始系列文章分享的,这里就先穿越下,提前安排微服务应用的开篇文章 电商系统升级之微服务架构的应用。

本博客以及公众号坚持以架构的思维来分享技术,不仅仅是单纯的分享怎么使用的demo。

先来回顾下我上篇文章 asp.net core 中identityserver4 授权中心之应用实战 中,电商架构由单体式架构拆分升级到多网关架构

然而升级之后问题又来了,由于之前增加了代理商业务并且把授权中心和支付网关单独拆出来了,这使得公司的业务订单量翻了几十倍,这个时候整个电商系统达到了瓶颈,如果再不找解决方案系统又得宕机了。

经过技术的调研及问题分析,导致这个瓶颈的问题主要有以下几个原因,只需要把下面问题解决就可以得到很大的性能提升

单表、单数据库(未进行读写分离),以致于订单数据持续暴增。为了一劳永逸的解决以上问题,经过技术的调研,决定对订单业务做如下升级改造:

es进行数据迁移(按年进行划分,并且进行读写分离,这里就不着重讲,下次来跟大家一起学习和分享)分布式缓存 (也不是本次的重点,后续再来跟大家学习和分享)经过升级后的架构图如下:

架构图说明:

单体式架构,为拆分的单体架构业务,其中在业务处理上夹杂了一层分布式缓存的处理微服务)微服务的相关概念我就不多说了,以下就先简单概况下微服务带来的利和弊。

docker、kubernets、jenkins、git等。说到单体架构拆分,那也不是随意拆分,是要有一定的原则,拆分的好是优势,拆分的不好是混乱。以下是我查阅资料以及我的经验总结出来的拆分原则

领域驱动设计去进行底层服务的设计,后续会单独分析该设计的相关文章)好了,到这里大家已经对微服务有了一定的理解,就不继续详细概述相关理念的东西,下面来直接撸代码,让大家熟悉微服务的应用。这里我使用 莫堇蕈 在github 上开源的微服务框架,框架源代码地址 : (我这里强烈推荐该框架,目前已经比较成熟的用于公司生产环境)

为了更好的维护开源项目以及技术交流,特意创建了一个交流群,群号:1083147206 有兴趣者开源加入交流

core-grpc 微服务框架的优势:jlion.netcore.orderservice 订单微服务我们用vs2019 创建控制台应用程序 选择框架.net core 3.1 命名为jlion.netcore.orderservice 后面简称订单服务,创建完后我们通过nuget包引入 core-grpc微服务框架,如下图:

目前core-grpc微服务框架,最新正式发布版本是 1.0.3

引用了core-grpc 后我们还需要安装一个工具vs rpc menu,这个工具也是大神免费提供的,图片如下:

由于微软官方下载比较慢,我这里共享到 百度网盘,百度网盘下载地址如下:

链接: https://pan.baidu.com/s/1twpma4_aerrsg-m0icmopw 提取码: cshs

如果通过下载后安装不是vs 集成安装方式,下载完成后需要关闭vs 2019相关才能正常安装。

vs rpc menu 工具说明如下:

订单服务项目 中创建orderrequest.proto文件,这个是grpc 的语法,不了解该语法的同学可以 点击 进行学习,地址:orderrequest.proto代码如下:

syntax = "proto3";

package jlion.netcore.orderservice.service.grpc;

//定义订单查找参数实体

message ordersearchrequest{

string orderid = 1; //定义订单id

string name = 2;

}

//定义订单实体

message orderrepsonse{

string orderid = 1;

string name = 2;

double amount = 3;

int32 count = 4;

string time = 5;

}

//定义订单查找列表

message ordersearchresponse{

bool success = 1;

string errormsg = 2;

repeated orderrepsonse data = 3;

}

上面主要是定义了几个消息实体,

我们再创建jlionorderservice.proto,代码如下:

syntax = "proto3";

package jlion.netcore.orderservice.service.grpc;

import "orderrequest.proto";

service jlionorderservice{

rpc order_search(ordersearchrequest) returns (ordersearchresponse){}

}

上面的代码中都可以看到最上面有 package jlion.netcore.orderservice.service.grpc 代码,这是声明包名也就是后面生成代码后的命名空间,这个很重要。

同时定义了jlionorderservice服务入口,并且定义了一个订单搜索的方法order_search,到这里我们已经完成了一小部分了。

再在jlionorderservice.proto文件里面右键 》选择grpc代码生成》grpc 代码 会自动生存微服务客户端代码 。

生存工具中具有如下功能:

jlion.netcore.orderservice.grpc 类库把刚刚通过工具生成的grpc客户端代码直接copy到 jlion.netcore.orderservice.grpc这个类库中(必须和上面grpc 的代码声明的package 一致)以下简称订单服务客户端,并且需要通过nuget包添加overt.core.grpc 的依赖,代码结构如下:

jlion.netcore.orderservice.grpc类库已经构建完成,现在让 jlion.netcore.orderservice 服务引用jlion.netcore.orderservice.grpc 类库

订单服务中 实现自己的ihostedservice创建hostservice类,继承ihostedservice代码如下:

public class hostedservice : ihostedservice

{

readonly ilogger _logger;

readonly jlionorderservicebase _grpcservimpl;

public hostedservice(

ilogger<hostedservice> logger,

jlionorderservicebase grpcservice)

{

_logger = logger;

_grpcservimpl = grpcservice;

}

//服务的启动机相关配置

public task startasync(cancellationtoken cancellationtoken)

{

return task.factory.startnew(() =>

{

var channeloptions = new list<channeloption>()

{

new channeloption(channeloptions.maxreceivemessagelength, int.maxvalue),

new channeloption(channeloptions.maxsendmessagelength, int.maxvalue),

};

grpcservicemanager.start(bindservice(_grpcservimpl), channeloptions: channeloptions, whenexception: (ex) =>

{

_logger.logerror(ex, $"{typeof(hostedservice).namespace.replace(".", "")}开启失败");

throw ex;

});

system.console.writeline("服务已经启动");

_logger.loginformation($"{nameof(jlion.netcore.orderservice.service).replace(".", "")}开启成功");

}, cancellationtoken);

}

//服务的停止

public task stopasync(cancellationtoken cancellationtoken)

{

return task.factory.startnew(() =>

{

grpcservicemanager.stop();

_logger.loginformation($"{typeof(hostedservice).namespace.replace(".", "")}停止成功");

}, cancellationtoken);

}

}

上面代码主要是创建宿主机并且实现了startasync 服务启动及stopasync 服务停止方法。

我们创建完hostedservicce代码再来创建之前定义的grpc服务的方法实现类jlionorderserviceimpl,代码如下:

public partial class jlionorderserviceimpl : jlionorderservicebase

{

private readonly ilogger _logger;

private readonly iserviceprovider _serviceprovider;

public jlionorderserviceimpl(ilogger<jlionorderserviceimpl> logger, iserviceprovider provider)

{

_logger = logger;

_serviceprovider = provider;

}

public override async task<ordersearchresponse> order_search(ordersearchrequest request, servercallcontext context)

{

//todo 从底层es中查找订单数据,

//可以设计成ddd 方式来进行es的操作,这里我就为了演示直接硬编码了

var response = new ordersearchresponse();

try

{

response.data.add(new orderrepsonse()

{

amount = 100.00,

count = 10,

name = "订单名称测试",

orderid = datetime.now.tostring("yyyymmddhhmmss"),

time = datetime.now.tostring()

});

response.data.add(new orderrepsonse()

{

amount = 200.00,

count = 10,

name = "订单名称测试2",

orderid = datetime.now.tostring("yyyymmddhhmmss"),

time = datetime.now.tostring()

});

response.data.add(new orderrepsonse()

{

amount = 300.00,

count = 10,

name = "订单名称测试2",

orderid = datetime.now.tostring("yyyymmddhhmmss"),

time = datetime.now.tostring()

});

response.success = true;

}

catch (exception ex)

{

response.errormsg = ex.message;

_logger.logwarning("异常");

}

return response;

}

}

再修改program代码,并把hostedservice和jlionorderserviceimpl 注入到容器中,代码如下:

class program

{

static void main(string[] args)

{

var host = new hostbuilder()

.useconsolelifetime() //使用控制台生命周期

.configureappconfiguration((context, configuration) =>

{

configuration

.addjsonfile("appsettings.json", optional: true)

.addenvironmentvariables();

})

.configurelogging(logger =>

{

logger.addfilter("microsoft", loglevel.critical)

.addfilter("system", loglevel.critical);

})

.configureservices(configureservices)

.build();

appdomain.currentdomain.unhandledexception += (sender, e) =>

{

var logfactory = host.services.getservice<iloggerfactory>();

var logger = logfactory.createlogger<program>();

logger.logerror(e.exceptionobject as exception, $"unhandledexception");

};

host.run();

}

/// <summary>

/// 通用di注入

/// </summary>

/// <param name="context"></param>

/// <param name="services"></param>

private static void configureservices(hostbuildercontext context, iservicecollection services)

{

//hostedservice 单例注入到di 中

services.addsingleton<ihostedservice, hostedservice>();

services.addtransient<jlionorderservicebase, jlionorderserviceimpl>();

}

}

到了这里简单的微服务已经编码完成,但是还缺少两个配置文件,我们创建appsettings.json配置文件和consulsettings.json 服务注册发现的配置文件

consulsettings.json配置文件如下:

{

"consulserver": {

"service": {

"address": "127.0.0.1:8500"// 你的consul 服务注册及发现配置地址

}

}

}

上面的地址配置只是简单的例子,我这里假定我的consul服务地址是 127.0.0.1:8500 等下服务启动是会通过这个地址进行注册。

appsettings.json配置文件如下:

{

"grpcserver": {

"service": {

"name": "jlionorderservice",

"port": 10001,

"hostenv": "serviceaddress",

"consul": {

"path": "dllconfigs/consulsettings.json"

}

}

}

}

我这里服务监听了10001 端口,后面注册到consul中也会看到该端口

官方完整的配置文件如下:

{

"grpcserver": {

"service": {

"name": "overtgrpcserviceapp", // 服务名称使用服务名称去除点:overtgrpcserviceapp

"host": "service.g.lan", // 专用注册的域名 (可选)格式:ip[:port=default]

"hostenv": "serviceaddress", // 获取注册地址的环境变量名字(可选,优先)环境变量值格式:ip[:port=default]

"port": 10001, // 端口自定义

"consul": {

"path": "dllconfigs/consulsettings.json" // consul路径

}

}

}

}

好了,订单服务已经全部完成了,订单服务服务整体结构图如下:

好了,我们这里通过命令行启动下jlionorderservice服务,生产环境你们可以搭建在docker 容器里面

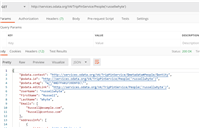

我们可以来看下我之前搭建好的consul服务 ,打开管理界面,如图:

图片中可以发现刚刚启动的服务已经注册进去了,但是里面有一个健康检查未通过,主要是由于服务端不能访问我本地的订单服务,所有健康检查不能通过。你可以在你本地搭建 consul服务用于测试。

我本地再来开启一个服务,配置中的的端口号由10001 改成10002,再查看下consul的管理界面,如下图:

发现已经注册了两个服务,端口号分别是10001 和10002,这样可以通过自定化工具自动添加服务及下架服务,分布式服务也即完成。

到这里订单服务的启动已经完全成功了,我们接下来是需要客户端也就是上面架构图中的电商业务网关或者支付网关等等要跟订单服务进行通讯了。

创建订单网关之前我先把上面的 订单服务客户端 类库发布到我的nuget包上,这里就不演示了。我发布的测试包名称jlionorderservicedemo nuget官方可以搜索找到。你们也可以直接搜索添加到你们的demo中进行测试。

我通过vs 2019 创建asp.net core 3.1 框架的webapi 取名为jlion.netcore.orderapiservice 下面简称订单网关服务

现在我把前面发布的微服务客户端依赖包 jlionorderservicedemo 添加到订单网关服务中,如下图:

现在在订单网关服务中添加ordercontroller api控制器,代码如下:

namespace jlion.netcore.orderapiservice.controllers

{

[route("[controller]")]

[apicontroller]

public class ordercontroller : controllerbase

{

private readonly igrpcclient<orderservice.service.grpc.jlionorderservice.jlionorderserviceclient> _orderservice;

public ordercontroller (igrpcclient<orderservice.service.grpc.jlionorderservice.jlionorderserviceclient> orderservice)

{

_orderservice = orderservice;

}

[httpget("getlist")]

public async task<list<orderrepsonse>> getlist()

{

var respdata =await _orderservice.client.order_searchasync(new orderservice.service.grpc.ordersearchrequest()

{

name = "test",

orderid = "",

});

if ((respdata?.data?.count ?? 0) <= 0)

{

return new list<orderrepsonse>();

}

return respdata.data.tolist();

}

}

}

代码中通过构造函数注入 orderservice 并且提供了一个getlist的接口方法。接下来我们还需要把orderservice.service.grpc.jlionorderservice注入到容器中,代码如下:

public void configureservices(iservicecollection services)

{

services.addcontrollers();

//注册grpc 客户端,具体可以查看源代码

services.addgrpcclient();

}

现在整个订单网关服务项目结构如下图:

项目中有两个最重要的配置dllconfig//jlion.netcore.orderservice.grpc.dll.json 和consulsettings.json 他们分别是干什么的呢?我们先分别来看我本地这两个配置的内容

jlion.netcore.orderservice.grpc.dll.json 配置如下:

{

"grpcclient": {

"service": {

"name": "jlionorderservice", // 服务名称与服务端保持一致

"maxretry": 0, // 最大可重试次数,默认不重试

"discovery": {

"consul": { // consul集群,集群优先原则

"path": "dllconfigs/consulsettings.json"

},

"endpoints": [ // 单点模式

{

"host": "127.0.0.1",

"port": 10001

}]

}

}

}

}

jlion.netcore.orderservice.grpc.dll.json 配置主要是告诉订单网关服务和订单服务应该怎样进行通信,以及通信当中的一些参数配置。我为了测试,本地使用单点模式,不使用consul模式

consulsettings.json 配置如下:

{

"consulserver": {

"service": {

"address": "127.0.0.1:8500"

}

}

}

有没有发现这个配置和之前服务端的配置一样,主要是告诉订单网关服务(客户端调用者)和订单服务服务端服务发现的集群地址,如果上面的配置是单点模式则这个配置不会起作用。

到这里订单网关服务 (客户调用端)编码完成,我们开始启动它:

我这里固定5003端口,现在完美的启动了,我们访问下订单接口,看下是否成功。访问结果如下图:

微服务完美的运行成功。

上面的构建微服务还是比较麻烦,官方提供了比较快速构建你需要的微服务方式,不需要写上面的那些代码,那些代码全部通过模板的方式进行构建你的微服务,有需要学习的可以到点击

教程地址:

文章中的demo 代码已经提交到github 上,代码地址:https://github.com/a312586670/identityserverdemo

微服务框架开源项目地址:

如对本文有疑问,请在下面进行留言讨论,广大热心网友会与你互动!! 点击进行留言回复

Blazor server side 自家的一些开源的, 实用型项目的进度之 CEF客户端

.NET IoC模式依赖反转(DIP)、控制反转(Ioc)、依赖注入(DI)

vue+.netcore可支持业务代码扩展的开发框架 VOL.Vue 2.0版本发布

网友评论