伴随着苹果全新一代iPhone智能手机iPhone 8、iPhone 8 Plus和iPhone X的发布,所有最初我们想了解的任何信息现在几乎都已一清二楚,包括零售价格、全新命名、机型数量,还有诸多最新功能等等,其实大多数信息在发布会之前就已经被爆料出来了。尽管如此,iPhone X、面部识别技术,以及AR现实增强技术这些新特性,依然十分引人注目。

不过,有一项可能苹果在发布会上或宣传中没有着重提及的特征,可能很多人忽视了它的存在,那就是强大的AI人工智能特性。

苹果新发布的三款机型均搭载了全新的移动芯片A11仿生,苹果表示A11仿生是iPhone上有史以来最强大、最智能的芯片。关于“最强大”这一点,通过昨天的Geekbench 4官方提供的基准测试数据我们已经了解到, A11定制的6核心CPU性能在移动领域已无敌手,全面领先市面上一切Android旗舰智能手机,与骁龙835比单核领先超过110%,多核也有55% 左右的领先。

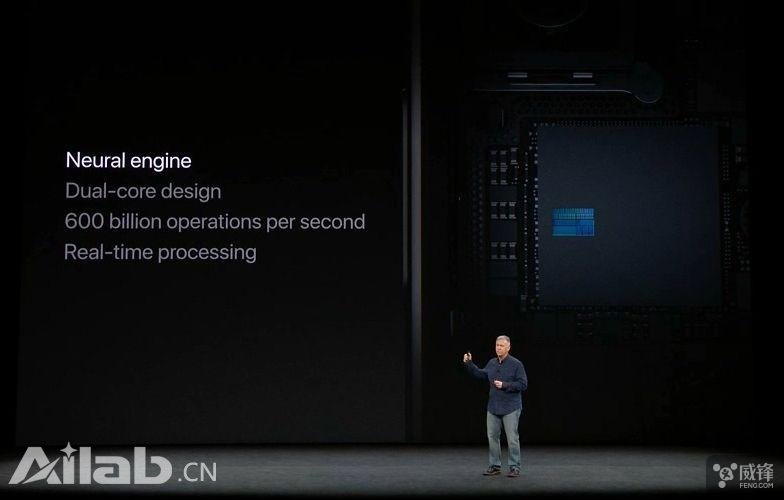

其实A11性能领先早已经是可以预料到的事情,不过“最智能”又在哪里呢?其实这与A11集成的神经网络引擎有非常大的关系。虽然苹果发布会这部分基本一笔带过,而且宣传低调,但不可否认的是,A11仿生成为了苹果第一枚神经网络引擎的SoC移动芯片,其神经网络引擎就是专门用于运行AI人工智能的处理单元,为此苹果在A11的命名上通过“仿生”特别突出了AI技术特征。

与 AI人工智能发展相冲突的隐私保护

在讨论神经网络引擎之前,我们先来说说苹果 AI人工智能的进程。众所周知,苹果是一家极其注重隐私的公司,之前很多例子已经足够证明这点。库克甚至一直对外宣称,苹果的保密性比美国 CIA还要高。

因此大量分析认为,正是隐私保护情节的阻碍让苹果失去了对 AI人工智能的主动权,最终导致今天在 AI人工智能竞赛中的落伍。苹果不仅在让设备更具人性化这方面落后于其他的科技巨头,而且在人工智能云计算方面的地位也很低,长期处于边缘化。为何这么说呢?

深度学习是 AI人工智能的一个分支学科,通常需要收集大量数据,并将这些数据聚合在云端,以便于深度了解,获得洞察力,但这些做法与苹果在数据保护上的严格立场不一致。苹果在 iOS 系统的 FaceTime 和 iMessage 应用中,使用的是端到端加密技术,并没有对用户的任何个人资料或信息进行维护或管理,这也与苹果对消费者数据保护的坚定观点保持一致。

虽然苹果的立场值得称赞,但是却让自身的 AI 发展难以前行,因为苹果自己也收集不到推进其 AI 人工智能发展所需的大数据,直到现在依然如此。

AI 的全新开始,并非重新开始

在今天移动互联网时代数据爆炸,大数据的出现让 AI 人工智能变得越来越好用。虽然很多移动设备的数据可以在云计算中得到更深入的分析,因为有例如 Google TPU,NVIDIA Volta 这种强大的 AI 运算解决方案。但问题是,数据需要花费一定时间才能到达云端,而苹果考虑隐私不会将数据传到云端,因此让一款移动设备提供略微接近云硬件的计算性能相当用必要。

苹果在发布会上解释称,有一种 AI 人工智能叫作机器学习,即让设备通过观察的方式进行学习。因此,一枚移动 SoC 芯片中,应该有专门负责虚拟神经元和深度学习的 AI 处理单元,而神经网络引擎就是专为机器学习而开发的硬件,它不仅能执行神经网络所需的高速运算,而且具有杰出的能效。

简而言之,通过神经网络引擎能够担 CPU 和 GPU 的任务,大幅提升芯片的运算效率,以更少的能耗更快的完成更多任务。在 A11仿生中,苹果自家的神经网络引擎采用双核设计,两个核心专为 AI 人工智能特定的机器学习算法而设计的,实时处理过程中,每秒运算次数最高可达6000亿次。

苹果表示,神经网络可以在 CPU 主处理单元或 GPU 图形处理单元上运行,但对于这种神经网络类型的编程模型,利用针对这些应用的定制芯片,在执行相同任务时,它将比使用图形引擎更加节能。神经网络引擎的神秘之处在于,它能够处理矩阵乘法和浮点处理的能力,分担 CPU 和 GPU 之外的特定任务,实现了硬件性能大幅改善。

其实苹果很早就十分清楚移动 AI 处理单元的趋势。几天前,苹果硬件技术高级副总裁斯强尼·斯洛基接受采访时表示,3年前发布搭载 A8芯片的 iPhone 6时,苹果就已经在开发 A11仿生芯片了,然而三年前移动行业关于 AI 和机器学习的话题还不多。斯强尼·斯洛基特别强调,“内置神经网络引擎是苹果在3年打的一个赌。”

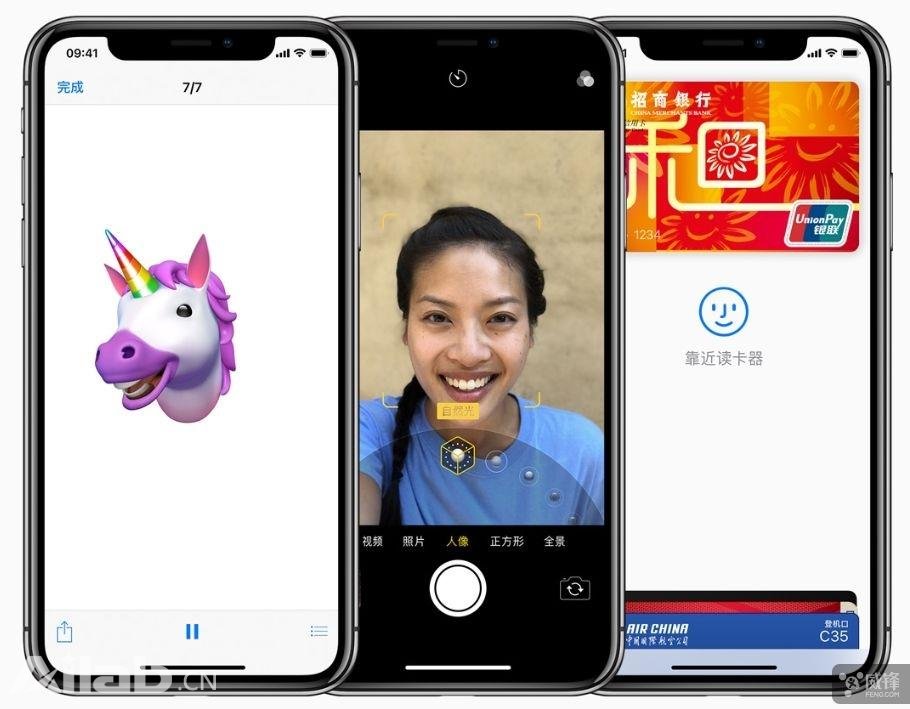

神经网络引擎服务于现在和未来

苹果称,有了“神经网络引擎服”的 A11 变得十分智能,因为能够把云端基于大数据深度学习训练成型的神经网络传输到手机中,与本地的神经网络引擎结合提供完整的 AI 知识和能力。而对于本地的 AI 人工智能处理,目前神经网络引擎已胜任诸多任务,包括更智能的够识别人物、地点和物体,为“面容 ID”和“动话表情”等创新的功能提供强大的性能等等。

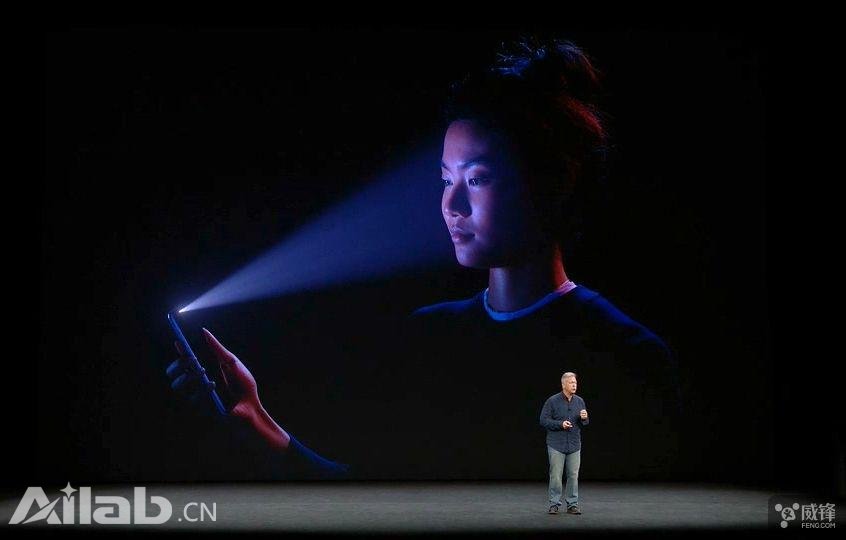

其中对于 iPhone X 的“面容 ID”就运用到了智能面部识别和机器学习这些 AI 人工智能技术。其原深感摄像头系统,通过泛光感应元件会借助不可见的红外光线,来“照亮”识别人的脸,然后点阵投影器将30000 多个肉眼不可见的光点投影在人脸部,绘制出精确细致、独一无二的深度面谱,而红外摄像头会探测点阵反射的细微变化,读取点阵图案,捕捉它的红外图像数据。?

关键是,被捕捉到的这些非常精确的红外图像和点阵图案的深度数据,将会被发送至 A11 仿生这枚芯片中的神经网络,创建脸部的数学模型,再将这些精准绘制面谱的数据发送至安全隔区,以确认数据是否匹配。苹果从来不会将生物识别的数据传输到网络上,面容 ID 功能的面谱数据同样如此。

与此同时,面容 ID 功能在神经网络引擎的 AI 人工智能技术下,就算人脸的样貌随着时间而改变,也能随之进行调整适应,哪怕是化妆、卸妆、戴上眼镜、帽子或留起胡须时也能一眼认出。一般使用照片或面具这种欺骗性手段来破解面容 ID,在 AI 技术下基本是不可能的事情。?

AI??技术除了服务于面容 ID 之外,新一代 iPhone 的相机系统也受益于此。例如人像模式自拍现在有了神经网络引擎的 AI 技术加持,景深虚化效果更加突出,而且所延伸出的“人像光效”这一特性,也利用到了 AI 复杂的算法,计算出容貌特征会怎样受到光线影响,利用数据创造出色的光效。至于“动话表情”,AI 技术能够让捕捉到的运动更准确的分析肌肉运动,以便于重现神态。

当然了,A11 的神经网络引擎是是苹果 AR 增强现实体验和 Siri 私人助理的核心,而且未来还将运用到更多方面,并扩展到更多苹果生态的领域当中,包括医疗健康相关应用、无人驾驶汽车系统、Apple Watch、Apple TV 和 HomePod 音箱等,让更多原本生硬的设备也能采用与人类同样的方式进行交互,变得真正会思考。

注重隐私的情况下,苹果 AI 将持续进步?

苹果是手机行业最早踏入 AI 人工智能领域厂商之一,早在2011 年就已经在 iPhone 当中首度集成 Siri 智能助理,为其提供相应的语音识别支持。A11 仿生芯片的亮相是苹果在 AI 人工智能领域的又一大动作,其神经网络引擎标志着全新的开始。尽管苹果??AI 人工智能目前仍落后于其他竞争对手,但利用神经网络引擎这种新的方式,苹果可以做到不侵犯用户隐私的情况下加速发展。

A11 仿生芯片集成的神经网络引擎,主要针对本地大量的数据处理,配合芯片本身强劲的处理能力,大幅提升认知能力,为用户本地提供最直达的服务,隐私数据本地处理的安全性毋庸置疑。而在本地 AI 处理能力强劲的情况下,还能配合发展多年的云端 AI 数据协同展开,进一步为设备提供完整的、高效的体验。

无论如何,在移动 SoC 集成 AI 人工智能处理单元这一全新模式上,苹果比其他竞争对手有更大的优势,重点就是苹果行业标杆的软硬结合实力以及成熟的生态圈。很多基于 AI 计算的功能,如面部识别、文本分析和语音识别等功能,开发者能够更迅速的将其运用到 app 里无缝切换于 CPU 和 GPU 之间,以提供最强的性能和效率。

同时,得益于庞大的生态圈和设备技术,一旦完成一项应用,便可迅速增殖到每一款 iOS 设备上,扩大适用范围,利用 AI 进一步体现出苹果独一无二的产品体验。苹果表示,“iPhone X 解锁了 iPhone 的下一个十年”,相信除了全面屏和面容 ID 之外,AI 神经网络引擎也将会是其中的关键点之一。

如对本文有疑问, 点击进行留言回复!!

阿尔麦斯机器人基地RMaaS正式启动 打造国内一流的机器人园区

聚焦LinearDesgin算法,百度跨界生物科学领域,打造AI强引擎

网友评论