本文经授权转载,其它媒体转载请经超能网同意。

现在深度学习已成为人工智能的重要方向,而且研究成果已经应用于日常使用中。但训练人工智能模型需要强大的算力支持,所以除了使用gpu加速训练外,很多厂商开始推出专用于深度学习训练的asic芯片。英特尔在人工智能领域投入颇多,除了fpga产品线外,也推出了nervana深度学习加速器,在今天的hot chips 31会议中,英特尔公布了旗下nervana nnp-t深度学习加速器的细节。

这款nervana nnp-t深度学习加速器代号为spring cast,是目前英特尔最新款的专用深度学习加速器。这款加速器被命名为nnp-t,表示其主要用于深度学习网络模型训练工作定制。随着深度学习模型越来越庞大,所以专用的训练加速器也逐渐流行起来,如nvidia也推出了tesla t4 gpu。

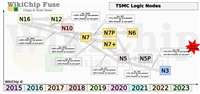

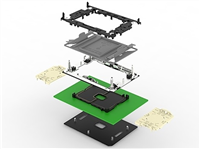

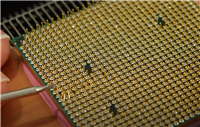

具体到加速器核心上,此次英特尔反常的使用了台积电16nm cln16ff+工艺,而实际上nervana在收购前就使用的是台积电28nm工艺制造其第一代的lake cast芯片。虽然使用的是台积电的工艺,但也是用了很多台积电的最新技术。芯片采用了4个8gb hbm2-2400内存,每针脚2.4gb/s的传输速率,都安装在一个巨大的1200平方毫米的硅基板上。同时计算核心与hbm内存通过台积电最新的cowos晶圆级封装技术进行互联。最终得到了一个60 x 60mm,具有3325 pin的bga封装。

在展示中称此次由于hbm2与核心是无源封装,所以为2.5d封装技术。而hbm2由于是4hi,所以整体为3d封装。实际上英特尔自家也有emib嵌入式多芯片互联桥接这种桥接技术。四个hbm2堆栈共有64条serdes通道,每个通道支持28gb/s的传输速率。

具体的核心规模上,nervana nnp-t的计算核心拥有270亿晶体管,包括24个tensor processors(tpc)。除了tpc外,芯片裸片中还有60mb的sram以及一些专用的接口,如ipmi、i2c及16条pci-e 4.0通道。

芯片的工作频率为1.1ghz,风冷条件下功率配置为150w到250w,可通过水冷获得更强大的性能表现。同时nervana nnp-t加速器还拥有ocp卡及pci-e两种规格,以供数据中心选择。

nervana nnp-t加速器充分利用内存模块和互联网络使得计算核心得以充分使用。计算核心支持bfloat16矩阵乘法、fp32、bf16以及其他主要操作。同时在使用上英特尔已经通过开源的ngraph库将深度学习框架连接到硬件后端的编译器。现在英特尔正在与常见的paddle paddle、pytorch及tensorflow深度学习框架进行合作。

由于采用了可扩展架构集ocp及pci-e规格,所以对于数据中心等场景可以方便地进行扩展。架构支持扩展到1024个节点,每个节点拥有8个nnp-t计算核心。

英特尔表示他们将在今年年底向客户提供nnp-t的样品,主要针对以及云服务提供商,在2020年之前面向更多用户。

如对本文有疑问, 点击进行留言回复!!

2年升级一次 Intel:10nm、7nm及5nm工艺开发不会削减投资

AMD推土机FX-8350超频至8.1GHz!却打不过3.6GHz锐龙

网友评论